Testy A/B dla wielu wydają się skomplikowane. Prowadzenie kampanii reklamowych na Facebooku, Google czy TikToku może być bardzo trudne, jeżeli nie będziemy przeprowadzali testów. Okazuje się jednak, że samo testowanie również rządzi się pewnymi prawami – pod warunkiem, że chcemy robić to dobrze i mieć pewność, że nie popełniamy błędów przy analizie.

W tym artykule omówimy sobie szczegółowo, na czym polegają testy A/B, co możemy testować, oraz jak robić to prawidłowo i mieć pewność, że nasze wnioski są właściwe.

Czym są testy A/B

Testy A/B to po prostu testy, porównujące między sobą dwa warianty – oznaczane jako A i B. Takie testy pozwalają nam wyłonić zwycięzcę, czyli np. grafikę, tekst, nagłówek, które poradziły sobie lepiej w naszej kampanii.

Istnieją też różne inne warianty testów A/B – np. testy A/B/n albo A/A, ale o wszystkich przykładach i zastosowaniach powiemy sobie w dalszych częściach artykułu.

Przykład

W ramach testu A/B możemy sprawdzić, który wariant naszej grafiki reklamowej poradzi sobie lepiej – czyli wygeneruje więcej kliknięć/konwersji przy tym samym budżecie.

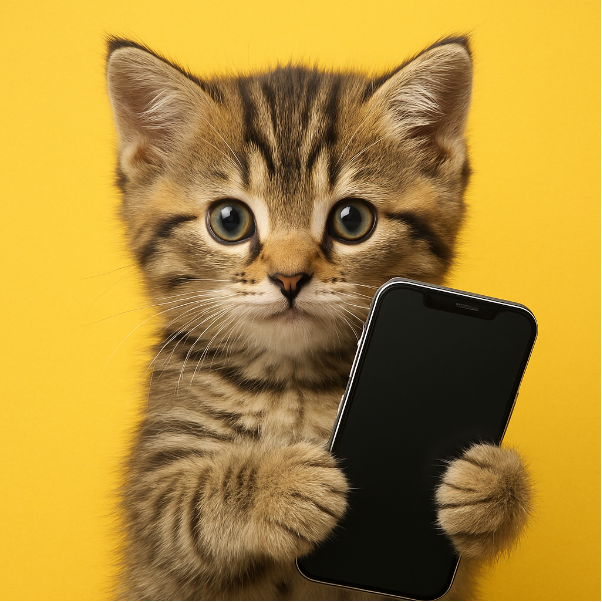

Mamy więc np. grafikę przedstawiającą kotka jako test A, oraz grafikę przedstawiającą pieska jako test B.

Aby przeprowadzić test, musimy następnie wykorzystać obie grafiki reklamowe w kampanii, z zapewnieniem, że każda z nich dostanie podobną (najlepiej: identyczną) kwotę budżetu. Dzięki temu będziemy mogli porównać, która grafika pozwoliła nam wygenerować więcej kliknięć z tego samego budżetu.

Jeśli dana grafika okaże się skuteczniejsza, to na tej podstawie będziemy mogli wyciągnąć wniosek, że wydawanie budżetu na tę wersję będzie po prostu bardziej optymalne. W dłuższej perspektywie, testując po kolei różne elementy reklamy, możemy ostatecznie wyłonić najskuteczniejszą kombinację materiałów i znacząco obniżyć koszty promocji (albo podnieść jej wydajność).

Co pomogą nam testować testy A/B?

Za pomocą testów A/B możemy sprawdzać najróżniejsze elementy naszej komunikacji marketingowej, ale również elementy naszej oferty, produktów, a nawet operacji. W zasadzie wszystko, co pozwala na zmierzenie swojej skuteczności, może być A/B-testowane.

Przyjrzyjmy się kilku najpopularniejszym przykładom testów A/B:

- Kreacje reklamowe – możemy testować całe kreacje, jak również tylko ich fragmenty. Szczególnie przydatne jest testowanie np. pierwszych 3 sekund reklamy video, ponieważ to początek ma największy wpływ na przykuwanie uwagi odbiorcy.

- Nagłówki reklamowe – możemy sprawdzać, które nagłówki skutkują większym zaangażowaniem naszych potencjalnych klientów.

- Całe teksty reklamowe – nie musimy ograniczać się do nagłówków, możemy przecież sprawdzać od razu całe teksty i na tej podstawie wyciągać wnioski co do dalszego kierunku komunikacji.

- Cele reklamowe – w reklamach na Facebooku możemy ustawić dwie identyczne kampanie pod względem materiałów i targetowania, ale z innymi celami reklamowymi, aby porównać ich skuteczność. Takie testy mogą wydawać się zbędne, jeśli chcemy np. generować zakupy – w końcu jest do tego dedykowany cel reklamowy. Jednak w praktyce czasami okazuje się, że inne, pośrednie cele (np. dodanie do koszyka) potrafią przekładać się na więcej zamówień, poprzez lepszą optymalizację kampanii na większej ilości danych o koszykach.

- Grupy odbiorców – nasze reklamy mogą być identyczne, z takimi samymi celami reklamowymi, ale wykorzystane grupy odbiorców mogą mieć inne ustawienia. To jeden z najpopularniejszych testów, jakie wykonujemy w Emerald Media, ponieważ pozwala wyznaczyć kierunek do dalszego optymalizowania materiałów reklamowych. Inaczej komunikujemy się do innych grup, więc warto ustalić w pierwszej kolejności właśnie grupy odbiorców 🙂

- Kolory i elementy na stronie – możemy testować dopiero elementy, które pojawiają się po otwarciu strony internetowej. Może to być zupełnie inny landing page, a może też być bardzo podobny, z drobnymi zmianami stylistycznymi czy ułożeniem elementów. To pozwala poprawić współczynnik konwersji na stronie i zwiększyć wydajność wszystkich pozostałych kampanii.

- Platformy marketingowe – w kampaniach reklamowych Meta możemy osobno przetestować wyświetlanie reklam na Facebooku i Instagramie, aby sprawdzić, która platforma lepiej rezonuje z naszą komunikacją.

Jak widzisz, testować można praktycznie wszystko – powyżej przedstawiłem jedynie kilka praktycznych przykładów.

Zastanówmy się jednak, jak przeprowadzać testy A/B w sposób, który pozwoli nam wyciągnąć miarodajne, wiarygodne wnioski.

Najważniejsze zasady testów A/B

Jak już widzisz, testować można praktycznie wszystko. Jak więc podejść do testów A/B, aby jeszcze wyciągnąć z nich jakieś sensowne wnioski?

Po pierwsze: testuj tylko jedną zmienną jednocześnie!

Jeśli chcesz sprawdzić, która grafika reklamowa przyniesie lepsze rezultaty, to nie możesz w tym samym czasie zmieniać też tekstu reklamy. Zmieniając więcej elementów na raz, możesz faktycznie otrzymać inne wyniki, ale nie masz pewności, co właściwie wpłynęło na tę zmianę. Być może grafika A była odrobinę lepsza od grafiki B, ale tekst pod grafiką A był znacznie gorszy od tekstu pod grafiką B. W takim przypadku kreacja A wypadnie gorzej w teście, pomimo, że sama grafika była lepsza, ale tekst zanieczyścił wyniki eksperymentu.

Gdybyśmy na poprzednim teście z pieskiem i kotkiem zmienili też ułożenie łap, kolor smartfona albo format, nasz test byłby trudny do ocenienia.

Po drugie: wyciągaj wnioski na podstawie wystarczającej próbki danych

Czasami chcielibyśmy szybko wyciągnąć informację na temat skuteczności dwóch zestawów reklam i już pierwszego dnia wyłonić zwycięzcę z naszego testu. W praktyce często jednak musimy zebrać odpowiednią ilość danych, aby wyciągnięcie wniosków było możliwe.

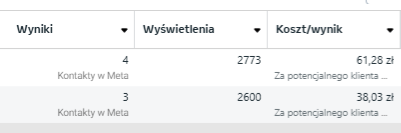

Klasyczna tego typu sytuacja, jaką często widzi się na koncie reklamowym:

W przypadku takiego rozkładu danych bardzo ciężko jest określić, który zestaw jest lepszy: pierwszy, czy drugi. Z jednej strony pierwszy zestaw wygenerował więcej kontaktów, ale koszt kontaktu jest lepszy w drugim zestawie. To sprawia, że ocenienie ich pod kątem wydajności i wyłonienie zwycięzcy jest niemożliwe na tym etapie.

Polecam narzędzie od Neila Patela: A/B Testing Calculator, które pozwala ocenić, czy wyniki naszych testów są sensowne pod względem statystycznym. Jeśli narzędzie, po wpisaniu wyników, podaje niejednoznaczne dane, to musimy powtórzyć test lub poczekać z wyborem zwycięzcy.

Po trzecie: nigdy nie przestawaj testować

To, że udało nam się wyciągnąć sensowne wnioski z testów A/B, nie oznacza, że możemy zapisać je na zawsze i nigdy do nich nie wracać. Czasy się zmieniają, rynek ewoluuje, a Twoje testy mogą za jakiś czas być już nieaktualne.

To samo zjawisko można zaobserwować, jak uruchomi się ponownie starą kampanię, która generowała dobre rezultaty rok czy dwa lata temu. Zwykle nowe stawki i wyniki, jakie osiąga, znacząco odbiegają od tego, czego się spodziewaliśmy.

Jeśli przetestujesz np. opcje targetowania i wyciągniesz sensowne wnioski, możesz zacząć testować kolejne zmienne, ale nie zapomnij wrócić do targetowania za jakiś czas. Być może po 6-12 miesiącach coś już się zmieniło na rynku i trzeba to ponownie sprawdzić za pomocą testów A/B.

Testy A/B – najczęstsze błędy

Oprócz oczywistych dobrych praktyk przy testach, nie zapominajmy też o najczęstszych błędach, jakie zdarza nam się popełniać – często nawet nieświadomie.

Wyciąganie pochopnych wniosków z małej próby

Pierwszy błąd w testach A/B to wyciąganie wniosków, zanim nasz eksperyment osiągnie statystyczną wartość. Podawałem powyżej kalkulator statystyczny od Neila Patela i sugeruję korzystać z niego za każdym razem, kiedy tylko masz wątpliwości wobec wyników.

Pamiętaj także, że wyciąganie wniosków na małej próbie może być mylące, biorąc pod uwagę dużą zmienność algorytmów reklamowych. Zawsze, kiedy masz już pierwsze wnioski odnośnie zwycięzcy testu, warto poczekać jeszcze 1-2 dni i sprawdzić, czy w ostatnich dniach tendencja się utrzymała. Jeśli analiza ostatnich dni dałaby inne rezultaty, warto przedłużyć lub przeprowadzić ponownie cały test, dla pewności.

Zakładanie, że niektóre elementy nie wymagają testowania

To chyba jeden z grzechów głównych marketerów: wydaje nam się, że znamy odpowiedzi na różne pytania, bo tak podpowiada nam intuicja.

Owszem, często można przyspieszyć niektóre procesy, bazując na swoim doświadczeniu branżowym i wypracowanych schematach, które się sprawdzają. Często jednak lubimy stosować intuicję zbyt często i z góry zakładać, że np. określone opcje targetowania będą skuteczne w kampanii, albo że jakiś styl komunikacji dobrze trafi do naszych klientów.

Pamiętaj: nigdy nie możemy być niczego pewni, dopóki tego nie przetestujemy. Nawet nasze doświadczenia i branżowe smaczki warto od czasu do czasu poddawać próbie.

Przykład: tworzyliśmy kiedyś kampanię na generowanie leadów w branży kredytowej. Klientem był pośrednik kredytowy dla firm, poszukujący małych przedsiębiorców zainteresowanych udzieleniem im pożyczki.

Oczywistym zainteresowaniem, jakie przetestowaliśmy w pierwszej kolejności, była opcja w targetowaniu na Facebooku: “Kredyt i pożyczka”. Taka opcja wydawała się wręcz idealna w tego typu kampanii.

Pierwsze testy wykazały nawet, że faktycznie zestaw reklam wykorzystujący to zainteresowanie generuje leady znacznie niższym kosztem. Po czasie okazało się jednak, że do formularza wpadały głównie osoby, które wypełniały wszystkie możliwe wnioski i podania o kredyty… bo w większości miejsc dostawały z automatu odmowę. Tym samym były one częściej wrzucane przez Facebooka do zainteresowania “Kredyt i pożyczka”, ale w przypadku naszej kampanii okazało się, że lepszą skuteczność i konwersję osiągamy w momencie, kiedy korzystamy z wykluczenia tej opcji.

Bez odpowiedniego testu A/B nie wiedzielibyśmy, z czego wynika problem z tak niską jakością leadów – zwłaszcza, że problem leżał w założeniu, które wszystkim osobom zaangażowanym w projekt wydawało się oczywiste.

Błąd przeżywalności

Błąd przeżywalności to klasyczny błąd poznawczy (ang. cognitive bias), charakteryzujący się tym, że wyciągamy wnioski z niepełnej próby badawczej, podczas gdy pełna próba badawcza mogłaby prezentować zupełnie inne wnioski.

Przykład: podczas II wojny światowej angielscy inżynierowie analizowali samoloty, które wracały z bitew. Oceniali oni uszkodzenia samolotów, które przetrwały, i projektowali dodatkowe wzmocnienia i zbrojenia w miejscach, które były najbardziej zniszczone – czyli w ich ocenie: najbardziej narażone na strzały.

Ku ich zdziwieniu, nie poprawiło to skuteczności samolotów. Nadal z bitew wracało ich mniej-więcej tyle samo, a więc ulepszenia nie zwiększyły ich ochrony. Dopiero pan Abraham Wald, amerykańsko-węgierski statystyk, zrozumiał, że powinni badać te samoloty, które… nie wróciły. Samoloty, które wróciły, zwykle obrywały w miejscach, które nie miały tak kluczowego znaczenia dla ich przetrwania. Zatem te samoloty, które zostały zniszczone, prawdopodobnie miały obrażenia w innych obszarach – i te obszary zostały ostatecznie wzmocnione, co znacząco poprawiło skuteczność samolotów w walce.

W naszych kampaniach marketingowych błąd przeżywalności może przyjmować nieco inne odmiany – na przykład jeśli wyciągamy wnioski z testów A/B na mocno zawężonej grupie docelowej, którą wytypowaliśmy w poprzednich testach, mogą być one niewłaściwe dla całej grupy docelowej.

Nierównomierne dane w próbie

Bardzo częstym błędem w testach A/B jest wyciąganie wniosków relatywnych do budżetu, jaki został wydany na dwa różne przypadki. W reklamach na Facebooku normą jest, że różne zestawy czy kreacje wydają inne kwoty budżetu i osiągają inne rezultaty. Ponieważ Facebook rozkłada budżet w sposób dynamiczny, może się okazać, że najlepiej radząca sobie kreacja wcale nie dostała największego budżetu… a przynajmniej możemy mieć takie złudzenie.

Zjawisko, o którym mówimy, to tzw. breakdown effect. Polega ono na tym, że im większy budżet przeznaczymy na daną kampanię/zestaw/kreację, tym gorsza będzie jej skuteczność, ponieważ kolejne wyświetlenia będą trafiały do coraz mniej dopasowanych odbiorców.

Wobec tego, nawet najlepsza reklama, po zwiększeniu kilkukrotnie budżetu, będzie generowała konwersje z wyższym średnim kosztem, niż inne reklamy, które otrzymały tego budżetu mniej. Cała magia polega na tym, że gdybyśmy rozłożyli budżet równomiernie, prawdopodobnie ta reklama nadal miałaby najlepszy średni koszt za konwersję, więc w praktyce wszystko gra, aczkolwiek na poziomie analizy łatwo popełnić błąd.

Testy A/B – Podsumowanie

Testy A/B to jedno z podstawowych narzędzi dobrego marketera. Pozwala na wyciąganie wniosków i podpieranie się nimi przy późniejszych działaniach.

Sam często powtarzam, że praca marketingowca to tak naprawdę ciągłe stawianie tez i sprawdzanie, czy są one zgodne z prawdą. Jednym ze sposobów na to sprawdzanie są właśnie odpowiednio zaprojektowane eksperymenty i testy, które pozwalają nam przybliżać się do grupy docelowej.

Pamiętaj też o jednej, bardzo ważnej zasadzie: testuj wszystko, niezależnie od swojej intuicji. Wyniki testów mogą Cię zaskoczyć, albo pokazać, że masz rację od samego początku 😉